ÚüŞŔç¬MachineLearningMastery

ńŻťŔÇů´╝ÜJason Brownlee

ňĆâŔłç´╝ÜNurhachu NullŃÇüŔ̻ڍ¬

šĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőňťĘňĄÜňÇőÚáśňččň▒ĽšĆżňç║ňůłÚÇ▓Š░┤ň╣│´╝îńŻćÚÇ֚ʫšÁÉŠžőŠťâň░çŔ╝Şňůąň║ĆňłŚšĚĘšó╝šé║ňŤ║ň«ÜÚĽĚň║ŽšÜäňůžÚâĘŔíĘňżÁŃÇéÚÇÖÚÖÉňłÂń║ćŔ╝Şňůąň║ĆňłŚšÜäÚĽĚň║Ž´╝îń╣čň░ÄŔç┤ŠĘíň×őň░Źšë╣ňłąÚĽĚšÜäŔ╝Şňůąň║ĆňłŚšÜäŠÇžŔâŻŔ«ŐňĚ«ŃÇéň░çŠ│ĘŠäĆňŐŤŠęčňłÂň╝Ľňůąňż¬šĺ░šą×šÂôšÂ▓šÁíň╣źňŐęŔžúŠ▒║ÚÇÖńŞÇň▒ÇÚÖÉŠÇžŃÇéŔę▓Šľ╣Š│ĽňĆ»šöĘŠľ╝ňĄÜňÇőÚáśňččšÜäň║ĆňłŚÚáÉŠŞČńŞş´╝îňîůŠőČŠľçŠťČš┐╗Ŕş»ŃÇüŔ¬×Úč│ŔşśňłąšşëŃÇé

šĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőŠÁüŔíîšÜäňÄčňŤáŠś»ň«âňťĘšťżňĄÜÚáśňččň▒ĽšĆżňç║ń║暼Âň돊ťÇÚźśŠ░┤ň╣│ŃÇéÚÇ֚ʫšÁÉŠžőšÜäň▒ÇÚÖÉŠÇžňťĘŠľ╝ň«âŠťâň░çŔ╝Şňůąň║ĆňłŚšĚĘšó╝šé║ňŤ║ň«ÜÚĽĚň║ŽšÜäňůžÚâĘŔíĘňżÁŃÇéÚÇÖÚÖÉňłÂń║ćŔ╝Şňůąň║ĆňłŚšÜäÚĽĚň║Ž´╝îńŞŽńŞöň░ÄŔç┤ŠĘíň×őň░Źšë╣ňłąÚĽĚšÜäŔ╝Şňůąň║ĆňłŚšÜäŠÇžŔâŻŔ«ŐňĚ«ŃÇé

ňťĘÚÇÖš»çňŹÜň«óńŞş´╝ĹňÇĹň░çšÖ╝šĆżňĆ»ń╗ąňťĘňż¬šĺ░šą×šÂôšÂ▓šÁíńŞşŠÄíšöĘŠ│ĘŠäĆňŐŤŠęčňłÂ´╝łattention mechanism´╝ëńżćňůőŠťŹÚÇ֚ʫň▒ÇÚÖÉŠÇžŃÇé

Ŕ«Çň«îÚÇÖš»çňŹÜň«ó´╝îńŻáŠťâščąÚüô´╝Ü

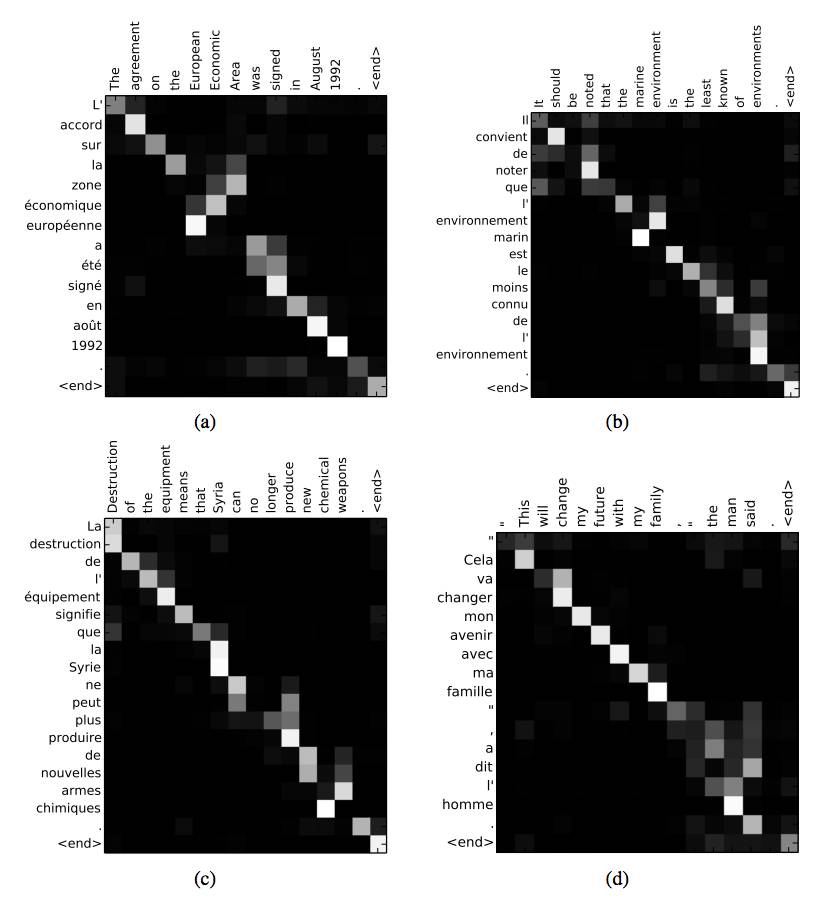

šĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőňĺîňŤ║ň«ÜÚĽĚň║ŽňůžÚâĘŔíĘňżÁšÜäň▒ÇÚÖÉŠÇž

Ŕ«ôšÂ▓šÁíňşŞŠťâÚçŁň░ŹŔ╝Şňç║ň║ĆňłŚšÜ䊻ĆńŞÇÚáůňÄ╗Š│ĘŠäĆŔ╝Şňůąň║ĆňłŚńŞşň░ŹŠçëńŻŹšŻ«šÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

ňŞÂŠťëŔĘ╗ŠäĆňŐŤŠęčňłÂšÜäňż¬šĺ░šą×šÂôšÂ▓šÁíňťĘŠľçŠťČš┐╗Ŕş»ŃÇüŔ¬×Úč│Ŕşśňłąšşë 5 ňÇőÚáśňččńŞşšÜäŠçëšöĘŃÇé

ÚĽĚň║ĆňłŚšÜäňĽĆÚíî

ňťĘšĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘňż¬šĺ░šą×šÂôšÂ▓šÁíńŞş´╝îńŞÇš│╗ňłŚÚĽĚščşŠťčŔĘśŠćšÂ▓šÁí´╝łLSTM´╝ëňşŞš┐ĺň░çŔ╝Şňůąň║ĆňłŚšĚĘšó╝šé║ňŤ║ň«ÜÚĽĚň║ŽšÜäňůžÚâĘŔíĘňżÁ´╝îňĆŽńŞÇÚâĘňłćڼ̚躊ťčŔĘśŠćšÂ▓šÁíŔ«ÇňĆľňůžÚâĘŔíĘňżÁńŞŽň░çň«âŔžúšó╝ňł░Ŕ╝Şňç║ň║ĆňłŚńŞşŃÇéÚÇ֚ʫšÁÉŠžőňťĘňŤ░ÚŤúšÜäň║ĆňłŚÚáÉŠŞČňĽĆÚíî´╝łńżőňŽéŠľçŠťČš┐╗Ŕş»´╝ëńŞşň▒ĽšĄ║ňç║ń║暼Âň돊ťÇňůłÚÇ▓šÜäŠ░┤ň╣│´╝îńŞŽŔ┐ůÚÇ芳ɚé║ń║ćńŞ╗ň░ÄŠľ╣Š│ĽŃÇéńżőňŽé´╝îńŞőÚŁóÚÇÖňůęš»çŔźľŠľç´╝Ü

ńŻ┐šöĘšą×šÂôšÂ▓šÁíšÜäň║ĆňłŚňł░ň║ĆňłŚňşŞš┐ĺ´╝łSequence to Sequence Learning with Neural Networks, 2014´╝ë

ńŻ┐šöĘ RNN šĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘňşŞš┐ĺščşŔ¬×ŔíĘňżÁ´╝îšöĘŠľ╝šÁ▒ŔĘłŠęčňÖĘš┐╗Ŕş»´╝łLearning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation, 2014´╝ë

šĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőń╗ŹšäÂŔâŻňĄáňťĘňżłňĄÜňĽĆÚíîńŞŐň»ŽšĆżň䬚žÇšÜäšÁɊםŃÇéšäÂŔÇî´╝îň«âňĆŚňł░ń║ćńŞÇňÇőÚÖÉňłÂ´╝îňŹ│ŠëÇŠťëšÜäŔ╝Şňůąň║ĆňłŚÚâŻŔóźň╝ĚňłÂšĚĘšó╝ŠłÉňŤ║ň«ÜÚĽĚň║ŽšÜäňůžÚâĘňÉĹÚçĆŃÇéÚÇÖńŞÇň▒ÇÚÖÉŠÇžÚÖÉňłÂń║ćÚÇÖń║ŤšÂ▓šÁíšÜäŠÇžŔ⯴╝îň░ĄňůŠś»ŔÇâŠů«ňł░Š»öŔ╝âÚĽĚšÜäŔ╝Şňůąň║ĆňłŚŠÖé´╝îńżőňŽéŠľçŠťČš┐╗Ŕş»ńŞşšÜäÚĽĚňĆąňşÉŃÇé

ŃÇîÚÇ֚ʫšĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘŠľ╣Š│ĽšÜäńŞÇňÇőŠŻŤňťĘňĽĆÚí»šą×šÂôšÂ▓šÁíÚťÇŔŽüŠŐŐŠ║ÉňĆąňşÉńŞşšÜäŠëÇŠťëň┐ůŔŽüń┐íŠü»ňúôšŞ«ŠłÉńŞÇňÇőňŤ║ň«ÜÚĽĚň║ŽšÜäňÉĹÚçĆŃÇéÚÇÖńŻ┐ňżŚšą×šÂôšÂ▓šÁíňťĘŔÖĽšÉćÚĽĚňĆąňşÉ´╝îň░ĄňůŠś»Š»öŔĘôšĚ┤Ŕ¬×ŠľÖÚĽĚšÜäňĆąňşÉŠÖ銝⊻öŔ╝âňŤ░ÚŤúŃÇéŃÇŹ

——Dzmitry Bahdanau, et al.,Neural machine translation by jointly learning to align and translate, 2015

ň║ĆňłŚńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

Š│ĘŠäĆňŐŤŠęčňłÂŠś»ńŞÇňÇőň░çšĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőňż×ňŤ║ň«ÜÚĽĚň║ŽšÜäňůžÚâĘŔíĘňżÁńŞşŔžúŠöżňç║ńżćšÜ䊾╣Š│ĽŃÇéň«âÚÇÜÚüÄń┐ŁŠîü LSTM šĚĘšó╝ňÖĘň░ŹŔ╝Şňůąň║ĆňłŚŠ»ĆńŞÇŠşąšÜäńŞşÚľôŔ╝Şňç║šÁɊם´╝îšäÂňżîŔĘôšĚ┤ŠĘíň×őňşŞš┐ĺňŽéńŻĽÚüŞŠôçŠÇžňť░ÚŚťŠ│ĘŔ╝Şňůą´╝îńŞŽň░çň«âňÇĹŔłçŔ╝Şňç║ň║ĆňłŚńŞşšÜäÚáůŔü»š╣źŔÁĚńżćŃÇéŠĆŤňĆąŔę▒Ŕ¬¬´╝îŔ╝Şňç║ň║ĆňłŚńŞşšÜ䊻ĆńŞÇÚáůÚâŻňĆľŠ▒║Šľ╝Ŕ╝Şňůąň║ĆňłŚńŞşŔóźÚüŞńŞşšÜäÚáůŃÇé

ŃÇîŔźľŠľçńŞşŠĆÉňç║šÜäŠĘíň×őňťĘš┐╗Ŕş»šÜäŠÖéňÇÖŠ»Ćšö芳ÉńŞÇňÇőŔę×´╝îň░▒ŠťâňťĘŠ║ÉňĆąňşÉńŞşšÜäńŞÇš│╗ňłŚńŻŹšŻ«ńŞşŠÉťš┤óŠťÇšŤŞÚŚťń┐íŠü»ÚŤćńŞşšÜäňť░Šľ╣ŃÇéšäÂňżîň«âŠťâňč║Šľ╝ńŞŐńŞőŠľçňÉĹÚçĆń╗ąňĆŐÚÇÖń║ŤŠ║ÉŠľçŠťČńŞşšÜäńŻŹšŻ«ňĺîń╣őň돚ö芳ɚÜ䚍«ŠĘÖŔę×ńżćÚáÉŠŞČńŞőńŞÇňÇőšŤ«ŠĘÖŔę×ŃÇéŃÇŹŃÇî……Ŕę▓ŠĘíň×őň░çŔ╝ŞňůąŔ¬×ňĆąšĚĘšó╝ŠłÉňÉĹÚçĆň║ĆňłŚ´╝îńŞŽňťĘŔžúšó╝š┐╗Ŕş»šÜäŠÖéňÇÖÚüęŠçëŠÇžňť░ÚüŞŠôçÚÇÖń║ŤňÉĹÚçĆšÜäňşÉÚŤćŃÇéÚÇÖńŻ┐ňżŚšą×šÂôš┐╗Ŕş»ŠĘíň×őńŞŹň┐ůňćŹň░çňÉäšĘ«ÚĽĚň║ŽšÜäŠ║ÉňĆąňşÉńŞşšÜäŠëÇŠťëń┐íŠü»ňúôšŞ«ŠłÉńŞÇňÇőňŤ║ň«ÜÚĽĚň║ŽšÜäňÉĹÚçĆŃÇéŃÇŹ

——Dzmitry Bahdanau, et al., Neural machine translation by jointly learning to align and translate (https://arxiv.org/abs/1409.0473), 2015

ÚŤľšäÂÚÇÖŠĘúňüÜŠťâňó×ňŐáŠĘíň×őšÜäŔĘłš«ŚŔ▓áŠôö´╝îńŻćŠś»ŠťâňŻóŠłÉšŤ«ŠĘÖŠÇžŠŤ┤ň╝ĚŃÇüŠÇžŔ⯊Ť┤ňąŻšÜäŠĘíň×őŃÇ銺ĄňĄľ´╝îŠĘíň×őÚéäŔâŻňĄáň▒ĽšĄ║ňťĘÚáÉŠŞČŔ╝Şňç║ň║ĆňłŚšÜäŠÖéňÇÖ´╝îňŽéńŻĽň░çŠ│ĘŠäĆňŐŤŠöżňťĘŔ╝Şňůąň║ĆňłŚńŞŐŃÇéÚÇÖŠťâň╣źňŐꊳĹňÇĹšÉćŔžúňĺîňłćŠ×ÉŠĘíň×őňł░ň║ĽňťĘÚŚťŠ│Ęń╗ÇÚ║╝´╝îń╗ąňĆŐň«âňťĘňĄÜňĄžšĘőň║ŽńŞŐÚŚťŠ│Ęšë╣ň«ÜšÜäŔ╝Şňůą-Ŕ╝Şňç║ň░ŹŃÇé

ŃÇîŔźľŠľçŠĆÉňç║šÜ䊾╣Š│ĽŔâŻňĄášŤ┤ŔžÇňť░ŔžÇň»čňł░šö芳Éň║ĆňłŚńŞşšÜ䊻ĆňÇőŔę×ŔłçŔ╝Şňůąň║ĆňłŚńŞşńŞÇń║ŤŔęךÜä´╝łŔ╗č´╝ëň░ŹÚŻŐÚŚťń┐é´╝îÚÇÖňĆ»ń╗ąÚÇÜÚüÄň░ŹŠĘÖŔĘ╗ŠČŐÚ珚ÜäňĆ»ŔŽľňîľńżćň»ŽšĆż……Š»ĆňÇőňťľńŞşščęÚÖúšÜ䊻ĆńŞÇŔíîń╗úŔíĘŔłçŠĘÖŔĘ╗šŤŞÚŚťŔü»šÜäŠČŐÚçŹŃÇéšö▒ŠşĄŠłĹňÇĹňĆ»ń╗ąšťőňç║ňťĘšö芳ɚŤ«ŠĘÖŔę׊Öé´╝îŠ║ÉňĆąňşÉńŞşšÜäňô¬ńŞÇňÇőńŻŹšŻ«ňĆŚňł░ń║ćÚçŹŔŽľŃÇéŃÇŹ

——Dzmitry Bahdanau, et al., Neural machine translation by jointly learning to align and translate (https://arxiv.org/abs/1409.0473), 2015

ńŻ┐šöĘňĄžň╣ůňťľšëçŠÖéšÜäňĽĆÚíî

ŠçëšöĘňťĘŔĘłš«ŚŠęčŔŽľŔŽ║ňĽĆÚíîńŞşšÜ䊏▓šęŹšą×šÂôšÂ▓šÁíń╣čÚŁóŔçĘÚí×ń╝╝ňĽĆÚíî´╝îšöĘšë╣ňłąňĄžšÜäňťľšëçŔĘôšĚ┤ŠĘíň×őŠťâňżłňŤ░ÚŤúŃÇéšö▒ŠşĄň╝ĽšÖ╝šÜäšÁɊםň░▒Šś»ňťĘňüÜňç║ÚáÉŠŞČń╣őň돴╝îňťľňâĆŠťâŔóźňĄžÚçĆŔžÇň»č´╝îňżŚňł░ňůÂŔ┐Ĺń╝╝ŔíĘšĄ║´╝łapproximate impression´╝ëŃÇé

ŃÇîń║║Úí׊äčščąšÜäńŞÇňÇőÚçŹŔŽüšë╣Ú╗×ň░▒Šś»ńŞŹŠťâňéżňÉĹŠľ╝ńŞÇŠČíŠÇžŔÖĽšÉćňá┤ŠÖ»šÜäňůĘŔ▓î´╝îŔÇ»ÚüŞŠôçŠÇžňť░ň░çŠ│ĘŠäĆňŐŤŔüܚ䎊ľ╝ŔŽľŔŽ║šę║ÚľôńŞşšÜäŠčÉń║ŤÚâĘňłćńżćšŹ▓ňĆľŠëÇÚťÇń┐íŠü»´╝îńŞŽńŞöšÁÉňÉłńŞŹňÉîŠÖéÚľôÚ╗ךÜäň▒ÇÚâĘń┐íŠü»ńżćŠžőň╗║ŠĽ┤ňÇőňá┤ŠÖ»šÜäňůžÚâĘŔíĘňżÁ´╝îń╗ąŠşĄŠîçň░ÄÚÜĘňżîšÜäšť╝ňőĽňĺîŠ▒║šşľŃÇéŃÇŹ

——Recurrent Models of Visual Attention (https://arxiv.org/abs/1406.6247), 2014

ÚÇÖń║Ťňč║Šľ╝ glimpse šÜäń┐«Šşúń╣čňĆ»ń╗ąŔóźŔ¬Źšé║Šś»Š│ĘŠäĆňŐŤŠęčňłÂ´╝îńŻćŠś»ńŞŽńŞŹŠś»ŠťČŠľçŔŽüŔ¬¬šÜäŠ│ĘŠäĆňŐŤŠęčňłÂŃÇé

šŤŞÚŚťŔźľŠľç´╝Ü

Recurrent Models of Visual Attention, 2014

DRAW: A Recurrent Neural Network For Image Generation, 2014

Multiple Object Recognition with Visual Attention, 2014

ńŻ┐šöĘŠ│ĘŠäĆňŐŤŠęčňłÂÚÇ▓Ŕíîň║ĆňłŚÚáÉŠŞČšÜä 5 ňÇőńżőňşÉ

ÚÇÖńŞÇÚâĘňłćšÁŽňç║ń║ćńŞÇń║Ťň░çŠ│ĘŠäĆňŐŤŠęčňłÂŔłçňż¬šĺ░šą×šÂôšÂ▓šÁíšÁÉňÉłŔÁĚńżćšöĘŠľ╝ň║ĆňłŚÚáÉŠŞČšÜäňůĚÚźöńżőňşÉŃÇé

1. ŠľçŠťČš┐╗Ŕş»ńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

ŠľçŠťČš┐╗Ŕş»ÚÇÖňÇőńżőňşÉŠłĹňÇĹňťĘňëŹÚŁóňĚ▓šÂôŠĆÉÚüÄń║ćŃÇéšÁŽň«ÜńŞÇňÇőŠ│ĽŔ¬×ňĆąňşÉšÜäŔ╝Şňůąň║ĆňłŚ´╝îň░çň«âš┐╗Ŕş»ńŞŽŔ╝Şňç║Ŕő▒ŠľçňĆąňşÉŃÇéŠ│ĘŠäĆňŐŤŠęčňłÂšöĘŠľ╝ŔžÇň»čŔ╝Şňůąň║ĆňłŚńŞşŔłçŔ╝Şňç║ň║ĆňłŚŠ»ĆńŞÇňÇőŔęךŤŞň░ŹŠçëšÜäňůĚÚźöňľ«Ŕę×ŃÇé

ŃÇîšö芳Ɋ»ĆňÇőšŤ«ŠĘÖŔę׊Öé´╝ĹňÇĹŔ«ôŠĘíň×őŠÉťš┤óńŞÇń║ŤŔ╝Şňůąňľ«Ŕę׊łľšö▒šĚĘšó╝ňÖĘŔĘłš«ŚňżŚňł░šÜäňľ«Ŕę׊ĘÖŔĘ╗´╝îÚÇ▓ŔÇîŠô┤ň▒Ľňč║ŠťČšÜäšĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőŃÇéÚÇÖŔ«ôŠĘíň×őńŞŹňćŹň┐ůÚáłň░犼┤ňÇőŠ║ÉňĆąňşÉšĚĘšó╝ŠłÉńŞÇňÇőňŤ║ň«ÜÚĽĚň║ŽšÜäňÉĹÚçĆ´╝îÚéäŔâŻŔ«ôŠĘíň×őňâůŔüܚ䎊ľ╝ňĺîńŞőńŞÇňÇőšŤ«ŠĘÖŔęךŤŞÚŚťšÜäń┐íŠü»ŃÇéŃÇŹ

——Dzmitry Bahdanau, et al., Neural machine translation by jointly learning to align and translate (https://arxiv.org/abs/1409.0473, 2015

Š│ĽŔ¬×-Ŕő▒Ŕ¬×š┐╗Ŕş»ńŞşšÜäŠ│ĘŠäĆňŐŤšĚĘŔş»

ňťľŠ│Ę´╝ÜňłŚšé║Ŕ╝Şňůąň║ĆňłŚ´╝îŔíîšé║Ŕ╝Şňç║ň║ĆňłŚ´╝îÚźśń║«ňíŐń╗úŔíĘń║îŔÇůšÜäÚŚťŔü»´╝îÚíĆŔë▓ŔÂŐŠĚ║´╝îňëçÚŚťŔü»ŠÇžŔÂŐň╝ĚŃÇé

ňťľšëçńżćŔç¬ŔźľŠľç´╝ÜDzmitry Bahdanau, et al., Neural machine translation by jointly learning to align and translate, 2015

2. ňťľňâĆŠĆĆŔ┐░ńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

Ŕłçglimpse Šľ╣Š│ĽńŞŹňÉî´╝îňč║Šľ╝ň║ĆňłŚšÜäŠ│ĘŠäĆňŐŤŠęčňłÂňĆ»ń╗ąŠçëšöĘňťĘŔĘłš«ŚŠęčŔŽľŔŽ║ňĽĆÚíîńŞŐ´╝îńżćň╣źňŐęŠëżňç║Šľ╣Š│Ľ´╝îńŻ┐Ŕ╝Şňç║ň║ĆňłŚŠÖ銍┤ňąŻňť░ňłęšöĘňŹĚšęŹšą×šÂôšÂ▓šÁíńżćÚŚťŠ│ĘŔ╝ŞňůąšÜäňťľšëç´╝îńżőňŽéňťĘňůŞň×őšÜäňťľňâĆŠĆĆŔ┐░ń╗╗ňőÖńŞşŃÇéšÁŽň«ÜńŞÇň╣ůŔ╝ŞňůąňťľňâĆ´╝îŔ╝Şňç║ň░ŹŔę▓ňťľňâĆšÜäŔő▒ŠľçŠĆĆŔ┐░ŃÇéŠ│ĘŠäĆňŐŤŠęčňłÂšöĘŠľ╝ÚŚťŠ│ĘŔłçŔ╝Şňç║ň║ĆňłŚńŞşšÜ䊻ĆńŞÇňÇőŔęךŤŞÚŚťšÜäň▒ÇÚâĘňťľňâĆŃÇé

ŃÇĹňÇĹŠĆÉňç║ń║ćńŞÇňÇőňč║Šľ╝Š│ĘŠäĆňŐŤŠęčňłÂšÜ䊾╣Š│Ľ´╝îŔę▓Šľ╣Š│ĽňťĘńŞëňÇőňč║Š║ľŠĽŞŠôÜÚŤćńŞŐÚâŻÚüöňł░ń║抝ÇňůłÚÇ▓šÜäŠÇžŔâŻŔíʚƿ……ŠłĹňÇĹÚéäň▒ĽšĄ║š×şňŽéńŻĽńŻ┐šöĘňşŞňżŚšÜäŠ│ĘŠäĆňŐŤŠęčňłÂšé║ŠĘíň×őšö芳ÉÚüÄšĘőŠĆÉńżŤŠŤ┤ňĄÜňĆ»ŔžúÚçőŠÇž´╝îŠ╝öšĄ║ń║ćňşŞňżŚšÜäň░ŹÚŻŐŔłçń║║ÚíךŤ┤ŔŽ║ńŞÇŔç┤ŠÇžňżłÚźśŃÇéŃÇŹ

—— Show, Attend and Tell: Neural Image Caption Generation with Visual Attention, 2016

Ŕ╝Şňç║ňľ«Ŕę×ŔłçŔ╝ŞňůąňťľňâĆšë╣ň«ÜňŹÇňččšÜäŠ│ĘŠäĆňŐŤšĚĘŔş»

ňĺîńŞŐňťľÚí×ń╝╝´╝îŔ╝Şňç║ŠľçŠťČńŞşńŞőňŐâšĚÜŔÖĽňľ«Ŕę×ň░ŹŠçëňĆ│ňü┤ňťľšëçńŞşšÜäŠ│ŤňůëňŹÇňččŃÇéňťľšëçńżćŔç¬ŔźľŠľç´╝ÜShow, Attend and Tell: Neural Image Caption Generation with Visual Attention, 2016

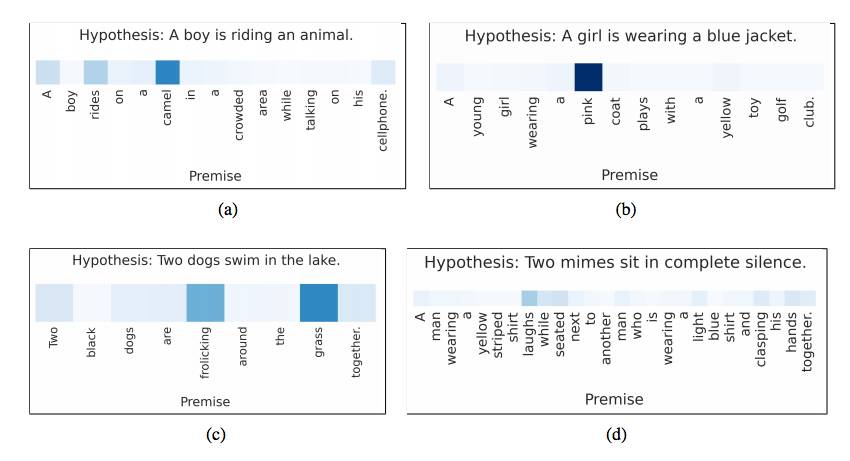

3. Ŕ¬×šżęŔśŐŠÂÁńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

šÁŽň«ÜńŞÇňÇőň돊ĆÉňá┤ŠÖ»´╝îńŞŽńŞöšöĘŔő▒ŠľçšÁŽňç║ÚŚťŠľ╝Ŕę▓ňá┤ŠÖ»šÜäňüçŔĘş´╝îŔ╝Şňç║ňůžň«╣Šś»ň돊ĆÉňĺîňüçŔĘşŠś»ňÉŽščŤšŤżŃÇüń║îŔÇůŠś»ňÉŽšŤŞń║ĺÚŚťŔü»´╝ľŔÇůň돊ĆÉŠś»ňÉŽŔśŐŠÂÁňüçŔĘşŃÇé

ńżőňŽé´╝Ü

ň돊ĆÉ:ŃÇîňęÜšŽ«ńŞŐšÜäšůžšëçŃÇŹ

ňüçŔĘş:ŃÇîŠčÉń║║ňťĘšÁÉňęÜŃÇŹ

Š│ĘŠäĆňŐŤŠęčňłÂšöĘŠľ╝ň░çňüçŔĘşńŞşšÜ䊻ĆńŞÇňÇőŔę×Ŕłçň돊ĆÉńŞşšÜäŔę×ÚŚťŔü»ŔÁĚńżć´╝îňĆŹń╣őń║ŽšäÂŃÇé

ŠłĹňÇĹŠĆÉňç║ń║ćńŞÇňÇőňč║Šľ╝ LSTM šÜ䚹ךÂôŠĘíň×ő´╝îň«âŔâŻňĄáň░çňůęňÇőňĆąňşÉŔ«ÇňĆľŠłÉńŞÇňÇőňĆąňşÉńżćÚÇ▓ŔíîŔ¬×šżęŔśŐŠÂÁňłćŠ×É´╝îŔÇîńŞŹŠś»ŠŐŐŠ»ĆňÇőňĆąňşÉÚ⯚ŹĘšźőňť░šĚĘšó╝ŠłÉńŞÇňÇőŔ¬×šżęňÉĹÚçĆŃÇéšäÂňżî´╝ĹňÇĹšöĘÚÇÉŔę׊│ĘŠäĆňŐŤŠęčňłÂ´╝łneural word-by-word attention mechanism´╝ëńżćŠô┤ň▒ĽŔę▓ŠĘíň×ő´╝îń╗ąÚ╝ôňőÁň░ŹŠłÉň░Źňľ«Ŕę×ňĺîŔęךÁ䊜»ňÉŽňşśňťĘŔśŐŠÂÁÚŚťń┐éńŻťňç║ŠÄĘšÉć……Ŕę▓Šô┤ň▒ĽŠĘíň×őšÜäňč║Š║ľŠŞČŔęŽňłćŠĽŞŠ»öLSTM Úźśń║ć2.6%´╝îňëÁÚÇáń║ćńŞÇÚáůŠľ░šÜäŠ║ľšó║šÄçŔĘśÚîä……

——Reasoning about Entailment with Neural Attention (https://arxiv.org/abs/1509.06664), 2016

ň돊ĆÉńŞşšÜäňľ«Ŕę×ňł░ňüçŔĘşńŞşňľ«ŔęךÜäŠ│ĘŠäĆňŐŤšĚĘŔş»ŃÇéňťľšëçńżćŔç¬ŔźľŠľç´╝ÜReasoning about Entailment with Neural Attention, 2016

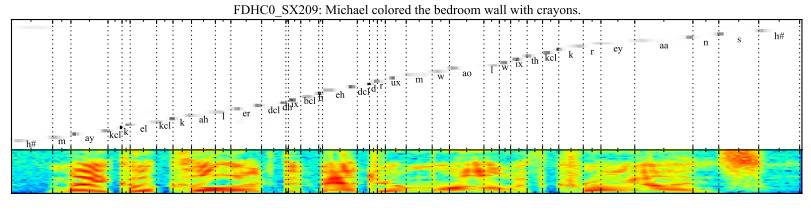

4. Ŕ¬×Úč│ŔşśňłąńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

šÁŽň«ÜńŞÇňÇőŔő▒ŠľçŔ¬×Úč│šë犫ÁńŻťšé║Ŕ╝Şňůą´╝îŔ╝Şňç║ńŞÇňÇőÚč│š┤áň║ĆňłŚŃÇéŠ│ĘŠäĆňŐŤŠęčňłÂŔóźšöĘńżćÚŚťŔü»Ŕ╝Şňç║ň║ĆňłŚńŞşšÜ䊻ĆńŞÇňÇőÚč│š┤áňĺîŔ╝Şňůąň║ĆňłŚńŞşšë╣ň«ÜšÜäŔ¬×Úč│ň╣ÇŃÇé

ŃÇî……ŠĆÉňç║ńŞÇňÇőŠľ░ň×őšÜäňč║Šľ╝ŠĚĚňÉłŠ│ĘŠäĆňŐŤŠęčňłÂšÜäšź»ňł░šź»ňĆ»ŔĘôšĚ┤šÜäŔ¬×Úč│ŔşśňłąšÁÉŠžő´╝îšé║ń║ćňťĘŔžúšó╝šÜäŠÖéňÇÖňťĘŔ╝Şňůąň║ĆňłŚńŞşÚüŞŠôçńŞőńŞÇňÇőńŻŹšŻ«´╝îň«âňÉîŠÖéšÁÉňÉłń║ćňůžň«╣ń┐íŠü»ňĺîńŻŹšŻ«ń┐íŠü»ŃÇéŔę▓ŠĘíň×őń╗Ąń║║Š╗┐ŠäĆšÜäńŞÇÚ╗׊ś»ň«âŔâŻňĄáŔşśňłąŠ»öŔĘôšĚ┤ŠëÇšöĘšÜäŔ¬×ŠľÖŠŤ┤ÚĽĚšÜäŔ¬×Úč│ŃÇéŃÇŹ

——Attention-Based Models for Speech Recognition (https://arxiv.org/abs/1506.07503), 2015.

Ŕ╝Şňç║Úč│š┤áňł░Ŕ╝ŞňůąŔ¬×Úč│ň╣ÇšÜäŠ│ĘŠäĆňŐŤšĚĘŔş»ŃÇéňťľšëçńżćŔç¬ŔźľŠľç´╝ÜAttention-Based Models for Speech Recognition, 2015.

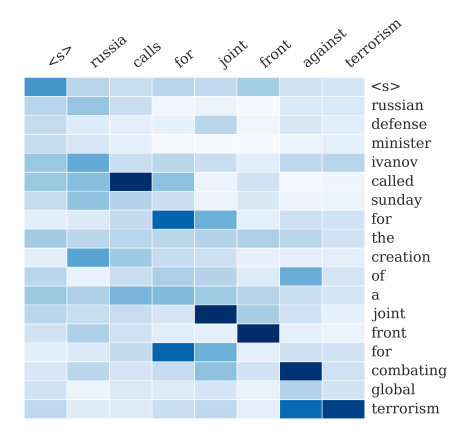

5. ŠľçŠťČŠĹśŔŽüńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂ

šÁŽň«ÜńŞÇŠ«ÁŔő▒ŠľçŠľçšźáńŻťšé║Ŕ╝Şňůąň║ĆňłŚ´╝îŔ╝Şňç║ńŞÇŠ«ÁŔő▒ŠľçŠľçŠťČńżćšŞŻšÁÉŔ╝Şňůąň║ĆňłŚŃÇéŠ│ĘŠäĆňŐŤŠęčňłÂŔóźšöĘńżćÚŚťŔü»ŠĹśŔŽüŠľçŠťČńŞşšÜ䊻ĆńŞÇňÇőŔę×Ŕ¬×ŔłçŠ║ÉŠľçŠťČńŞşšÜäň░ŹŠçëňľ«Ŕę×ŃÇé

ŃÇî……ŠĆÉňç║ńŞÇňÇőňč║Šľ╝ neutral attention ŠęčňłÂšÜäŠĘíň×őšöĘŠľ╝ŠŐŻŔ▒íŠĹśŔŽü´╝îŔę▓ŠĘíň×őňťĘŠťÇŔ┐Ĺšą×šÂôŠęčňÖĘš┐╗Ŕş»šÜäÚÇ▓ň▒Ľňč║šĄÄńŞŐšÖ╝ň▒ĽŔÇîńżćŃÇ銳ĹňÇĹň░çŔę▓ŠŽéšÄçŠĘíň×őŔłçńŞÇňÇőŔâŻňĄášö芳Ɋ║ľšó║ŠŐŻŔ▒íŠĹśŔŽüšÜäšö芳ɚ«ŚŠ│ĽšÁÉňÉłŔÁĚńżćŃÇéŃÇŹ

——A Neural Attention Model for Abstractive Sentence Summarization (https://arxiv.org/abs/1509.00685), 2015

Ŕ╝ŞňůąŠľçŠťČńŞşšÜäňľ«Ŕę×ŔłçŔ╝Şňç║ŠĹśŔŽüšÜäŠ│ĘŠäĆňŐŤšĚĘŔş»ŃÇéňťľšëçńżćŔç¬ŔźľŠľç´╝ÜA Neural Attention Model for Abstractive Sentence Summarization, 2015.

ň╗Âń╝ŞÚľ▒Ŕ«Ç

ňŽéŠ×ťńŻáň░ŹňťĘ LSTM ńŞşŠĚ╗ňŐáŔĘ╗ŠäĆňŐŤŠęčňłÂŠäčŔłłŔÂú´╝îňĆ»ń╗ąÚľ▒Ŕ«ÇńŞőÚŁóšÜäňůžň«╣´╝Ü

ŠĚ▒ň║ŽňşŞš┐ĺňĺîŔ笚äÂŔ¬×ŔĘÇŔÖĽšÉćńŞşšÜäŠ│ĘŠäĆňŐŤňĺîŔĘśŠć´╝łAttention and memory in deep learning and NLP´╝îhttp://www.wildml.com/2016/01/attention-and-memory-in-deep-learning-and- nlp/´╝ë

Š│ĘŠäĆňŐŤŠęčňłÂ´╝łAttention Mechanism´╝îhttps://blog.heuritech.com/2016/01/20/attention-mechanism/´╝ë

ňč║Šľ╝Š│ĘŠäĆňŐŤŠęčňłÂšÜäŠĘíň×őňťĘŔ笚äÂŔ¬×ŔĘÇŔÖĽšÉćńŞşšÜäŠçëšöĘ´╝łSurvey on Attention-based Models Applied in NLP´╝îhttp://yanran.li/peppypapers/2015/10/07/survey-attention-model-1.html´╝ë

[Quora ňĽĆšşö] ň░çŠ│ĘŠäĆňŐŤŠęčňłÂň╝Ľňůą RNN šęšźčŠś»ń╗ÇÚ║╝´╝č ´╝łWhat is exactly the attention mechanism introduced to RNN? https://www.quora.com/What-is-exactly-the-attention-mechanism-introduced-to-RNN-recurrent-neural-network-It-would-be -nice-if-you-could-make-it-easy-to-understand´╝ë

šą×šÂôšÂ▓šÁíńŞşšÜäŠ│ĘŠäĆňŐŤŠęčňłÂŠś»ń╗ÇÚ║╝´╝č ´╝łWhat is Attention Mechanism in Neural Networks? https://www.quora.com/What-is-Attention-Mechanism-in-Neural-Networks´╝ë

šŞŻšÁÉ

ÚÇÖš»çňŹÜŠľçń╗őš┤╣ń║ćňťĘ LSTM ňż¬šĺ░šą×šÂôšÂ▓šÁíńŞşńŻ┐šöĘŠ│ĘŠäĆňŐŤŠęčňłÂšöĘŠľ╝ň║ĆňłŚÚáÉŠŞČŃÇé

ňůĚÚźöŔÇîŔĘÇ´╝Ü

ňż¬šĺ░šą×šÂôšÂ▓šÁíńŞşšÜäšĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőńŻ┐šöĘňŤ║ň«ÜÚĽĚň║ŽšÜäňůžÚâĘŔíĘňżÁ´╝îšÁŽŔÂůÚĽĚň║ĆňłŚšÜäňşŞš┐ĺňŞÂńżćń║ćÚÖÉňłÂŃÇé

ÚÇÜÚüÄňůüŔĘ▒šÂ▓šÁíňşŞš┐ĺň░çŔ╝Şňç║ň║ĆňłŚńŞşšÜ䊻ĆńŞÇÚáůŔłçŔ╝Şňůąň║ĆňłŚńŞşšÜ䚍ŞÚŚťÚáůšŤŞň░ŹŠçë´╝îŠ│ĘŠäĆňŐŤŠęčňłÂňůőŠťŹń║ćšĚĘšó╝ňÖĘ-Ŕžúšó╝ňÖĘšÁÉŠžőšÜäÚÇ֚ʫň▒ÇÚÖÉŠÇžŃÇé

ÚÇ֚ʫŠľ╣Š│ĽňťĘňĄÜšĘ«ň║ĆňłŚÚáÉŠŞČňĽĆÚíîńŞşňżŚňł░ŠçëšöĘ´╝îňîůŠőČŠľçŠťČš┐╗Ŕş»ŃÇüŔ¬×Úč│ŔşśňłąšşëŃÇé

ňÄ芾çÚĆłŠÄą´╝Ühttp://machinelearningmastery.com/attention-long-short-term-memory-recurrent-neural-networks/

ŔŻëŔ▓╝Ŕ笴╝Ü easyAI

šĽÖńŞőńŻášÜäňŤ×Šçë

ń╗ąŔʬň«óň╝ÁŔ▓╝ňŤ×Šçë