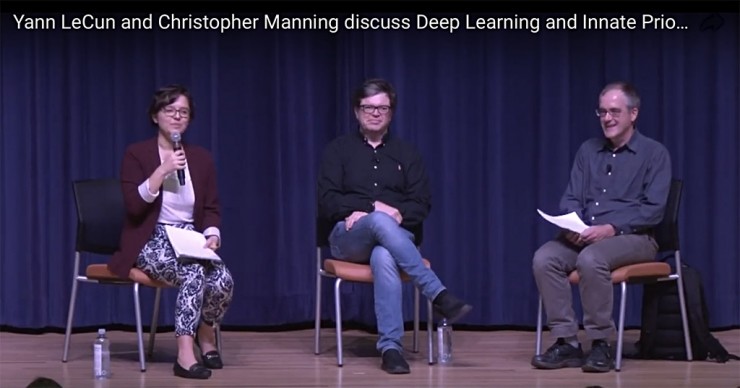

摘要: 近日,深度學習三駕馬車之一的 Yann LeCun 教授與斯坦福大學 NLP 掌門人 Christopher Manning 教授共同出席了斯坦福 AI 實驗室所舉辦的 AI 沙龍,一同討論了關於「什麼是我們應該加入到深度學習系統中的先驗知識」的話題。儘管兩位教授對此話題有着不同的觀點,但是專家之間思想的碰撞總能帶給大家很多啓發。

沙龍中所討論的主題是目前 AI 研究中很重要的一個問題:神經網絡中的結構設計,以及這些結構是如何與某些假設和歸納性先驗知識相對應的。事實上,去年就有研究者將「語言結構的迴歸」作爲 2017 年四大 NLP 深度學習研究趨勢之一。

Manning 教授提倡將更多的語言結構融入到深度學習系統中。而 LeCun 則認爲簡單而強大神經網絡結構就能夠執行復雜的任務,而不需要大量針對特定任務的特徵工程方法。出於這個原因,兩個人之間的學術理念有很大的分歧。對此,一個 Twitter 上的評論認爲,他們兩個就是 AI 領域中的蝙蝠俠大戰超人。

然而,LeCun 和 Manning 之間互相認同的地方可能超出大家的預期。LeCun 最著名的貢獻(卷積神經網絡)是完全基於先驗知識的:圖像處理系統應該具有平移不變性。這個基本假設也體現在了卷積神經網絡的結構設計中(權值共享)。而對於 Manning 而言,他曾經公開表示,深度學習的復興對於 NLP 來說是一件好事。

儘管兩位教授在這次討論中得到了很多共識,但是同樣也存在很多分歧。完整內容可以觀看討論視頻:https://youtu.be/fKk9KhGRBdI 。下面我們編譯了整個討論中出現的主要話題。

結構:必要的善,還是必要的惡

在 Manning 和 LeCun 的開場發言中,兩個人就確立了主要分歧。

Manning 認爲結構是「必要的善」(necessary good),他提出我們應該對網絡結構設計持積極的態度。相比於沒有結構設計的系統,一個精心設計的系統能夠從更少的數據中學到更多的知識,並且能夠在更高的抽象層次上學習。

相反,LeCun 將結構描述爲「必要的惡」(necessary evil),他警告說:使用結構需要我們做出某些假設,而這些假設總會在某些數據上是錯誤的,而且可能在不久的將來過時。同時還舉例說,ConvNet 可能在 10 年之內就會過時。

儘管存在分歧,但是我們應該注意到,LeCun 和 Manning 至少同意結構是「必要的」,儘管他們對這種必要性持相反的態度。

Manning 認爲加入更多結構設計是正確的,而且有是有道理的,比如,語言本質上就是遞歸的,因此 NLP 系統的結構也應該如此!比如,遞歸神經網絡(Recursive Neural Network,也叫做 Tree-RNN)在 NLP 中取得了成功,它就提出了遞歸語義合成性作爲先驗知識。然而,Manning 也承認,在實踐中很難做出正確的結構假設,同時這些假設也不總是能轉化爲性能提升。

LeCun 對結構設計的理想化程度則低得多。在討論過程中,他多次提到各種類型的結構(比如,殘差連接,卷積等),認爲它們僅僅是爲了網絡能夠優化到足夠工作的程度所需的「元級基礎」(meta-level substrate)。他認爲,一個沒有任何結構限制的類似網絡結構也可以很好的工作,只是可能需要更長時間的訓練。

當前 AI 的限制因素

LeCun 和 Manning 都注意到了目前 AI 研究在整個 AI 發展的歷史軌跡中所處的位置。在過去的幾十年裏,基於衆多先驗知識的方法已經過時,目前的深度學習研究更傾向於將嚴格監督端到端學習視爲主導範式(由大數據和豐富的計算資源所支持)。

LeCun 和 Manning 都一再強調這種範式的侷限性,例如在記憶,計劃,遷移學習,世界知識和多步推理方面都存在問題。同時他們都對目前通過結構設計以解決這些問題的方法表達了積極態度。

然而,Manning 更進一步,斷言現代深度學習的大數據大計算範式實際上已經「顛覆了計算語言學領域」並且「偏離了軌道」。他認爲,如果你能夠得到大量的數據和計算資源,你就能夠通過構建簡單但效率低下的系統獲得成功,而這個系統只需最表層的「最近鄰學習」。這阻礙了研究人員建立良好的學習系統:使用較少的數據,在較高抽象層次學習表示。他說這對整個領域都是不利的。而解決這個問題的答案就是,加入適當的結構,使系統能夠在正確的抽象層次上有效的學習概念。

儘管兩位教授有分歧,但是並不確定 LeCun 究竟是如何認爲 Manning 聲稱的深度學習在某種程度上「顛覆了這個領域」的。然而,LeCun 確實同意深度學習缺少一些基本的原理(想了解更多,請參閱他的CVPR 2015的演講,「深度學習有什麼問題?」)。

無監督學習的重要性

儘管討論涉及了當今人工智能技術的許多核心侷限性,但其中有一個特別迫切的且特殊的挑戰,也就是無監督學習,或者至少是少監督學習。

兩位教授都舉了一些例子:人類能夠進行小樣本學習(few-shot learning),人類能夠通過觀察瞭解世界,而無須任務或者外部獎勵。並且人類還可以在沒有明確監督的情況下學習具有離散結構的抽象概念(例如對象分類)。

他們認爲,這些無監督學習能力對 AI 的進步至關重要。但是,在結構應該在無監督學習革命中扮演什麼角色的問題上,LeCun 和 Manning 產生了分歧。

Manning 認爲加強結構是解鎖無監督學習的關鍵。他說,如果我們爲機器提供適當的結構工具,以在適當的抽象層級上學習,那麼他們就能夠在較少的監督下學習。

相反,LeCun 認爲,如果能夠進行無監督學習,那就不需要使用結構。比如,LeCun 舉例說人類的大腦並沒有任何先天的卷積結構,大腦並不需要這種結構,因爲作爲一個高效的無監督學習器,即使沒有卷積權值共享的約束,大腦同樣可以學習大量相同的低級圖像特徵(如方向邊緣檢測器)作爲 ConvNet。他總結說,對於我們目前的神經網絡架構使用更多的結構可能是徒勞的,因爲一旦我們開發出了更好的無監督學習方法,那些結構設計就會過時。

兩者觀點之間的差異很微妙,也許就是蛋生雞還是雞生蛋的區別。Manning 認爲結構是實現無監督學習的關鍵,而 LeCun 則將無監督學習當作學習結構的一個長期目標。

將結構作爲硬連接的先驗(hard-wired prior),還是從環境中學習

在討論過程中,很明顯至少有兩種類型的「結構」:作爲先驗嵌入到模型中結構(例如,ConvNet 中的卷積假設,或者遞歸神經網絡中的遞歸假設),和通過機器動態學習和計算出的結構(比如,通過膠囊網絡中動態路由計算出的結構,或注意力機制計算的關注區域)。兩者之間沒有一個簡單的區分方法,Manning 和 LeCun 在 ConvNet 層級結構應該屬於哪種結構的問題上持有不同的意見。

LeCun 一再反對硬連接先驗(hard-wired prior),它認爲所有結構都應該從環境中學習。雖然 Manning 同意應該從環境中學習到很多結構,但他也認爲我們(AI 系統的設計者)應該在提供這種結構方面起到一定的作用。雖然我們不應該回到人類設計複雜的系統(如 Chomskyan 文法)的時代,但他說,我們應該爲機器提供正確的「基礎和腳手架」以更有效地學習。

使用獎勵作爲先驗

LeCun 和 Manning 認爲理想情況下,獎勵應該是天生的,也就是說,正確地理解世界就是它自己的獎勵。比如,人類不斷的構建自己的世界模型,並根據外部觀察對其進行修改。

相比之下,今天大多數機器學習系統從外部提供的與特定任務密切相關的獎勵中學習。Manning 認爲目前這些目標函數定義的太過膚淺,他指出:如果將目標函數定義在如此低的水平,我們將永遠不會建立能夠學習抽象概念的 AI 系統。LeCun 認爲獎勵需要是本質的,豐富的,而不是從特定任務的獎勵中學習,AI 系統應該通過不斷預測「一切事物」來學習,而不需要訓練標籤或者任務定義。

關於語言

在討論的最後幾分鐘裏,LeCun 可能有些挑釁,他認爲語言「不那麼複雜」,也不是實現通用智能的關鍵。爲了支持他這一觀點,他說猩猩幾乎像人類一樣聰明,但他們並沒有語言。Manning 則捍衛語言的重要性作爲迴應,他認爲:語言對通用智能至關重要,因爲語言是將人智能共享並轉化爲社會智能的渠道。

在總長一個小時的對話裏,兩人還討論了許多其它的論文和學術思想,更多內容可以參見英文原博客 http://www.abigailsee.com/2018/02/21/deep-learning-structure-and-innate-priors.html ,以及現場視頻 https://youtu.be/fKk9KhGRBdI 。

轉貼自: 幫趣

留下你的回應

以訪客張貼回應