新買了一台只有USB-C插孔的筆電,手邊的滑鼠、隨身硬碟和耳機線全都不適用,該怎麼辦?這正是許多企業在導入AI時面臨的困境——AI需要存取數據,卻發現各種系統不兼容。 面對分散在不同來源、規格不一的各式數據,企業常見利用檢索增強生成(RAG)技術讓AI逐一調取資料,並投入資源開發專門的API介面來串接AI。模型上下文協定(Model Context Protocol, MCP)的出現正在化繁為簡,它讓AI就像擁有了一個「萬能轉接頭」,可以輕鬆存取並理解AI需要的各種數據,無需繁瑣的整合開發。 MCP究竟是什麼?它如何讓AI更聰明、更好用?

MCP(模型上下文協定)是什麼?

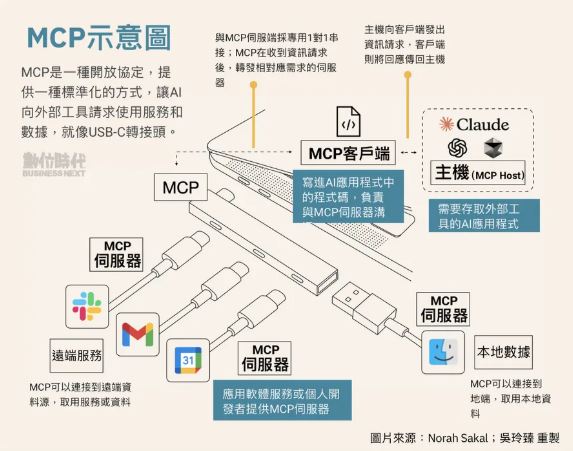

MCP全名為Model Context Protocol,中文為「模型上下文協定」,是一種開放協定,2024年11月由開發模型Claude的美國新創公司Anthropic推出,提供了一種標準化的方式,讓AI向外部工具請求使用服務和數據。並且透過提供AI上下文指示,讓AI決定使用哪些工具、按什麼順序以及如何將工作流程連結在一起以完成任務。 換句話說,MCP不只能當作轉接頭,也像是提供AI一本使用說明書,幫助AI理解企業數據和應用情境,例如內部數據的結構與存取方式、重要的業務邏輯與規則,以及專業術語等。 以銀行客服系統導入AI為例,當客戶詢問:「能否提前還清貸款?」MCP能提示AI該銀行的房貸規則在哪裡查詢、違約金計算方式,和哪些客戶符合提前還款條件等。 Anthropic應用AI團隊成員穆拉格(Mahesh Murag)指出,未來,MCP也可以作為AI代理(AI Agent)的基礎架構,提供檢索、記憶和工具調用的能力,使AI能夠更聰明、彈性地處理複雜任務,「我們希望MCP成為AI應用開發的標準層,讓開發者不再需要重複建構相同的基礎架構。」對於AI工具和API開發者來說,只需要建立一套MCP伺服器,就能讓各種大型語言模型(LLM)更方便地存取這些工具和數據源,而無需為每個模型單獨設計API介面。對於應用程式開發者來說,則可以將App連結到既有的MCP伺服器,使AI能夠透過MCP使用工具,節省自行撰寫API整合的時間。

MCP如何運作?

MCP不只適用於企業內部的AI工作流程,也有助於AI串接外部應用工具,就像筆電的轉接頭,統一不同的介面,確保筆電能夠與各種外部裝置連接。其中又包含MCP主機(Host)、MCP客戶端(Client)和MCP伺服端(Server)三端互動:MCP主機(MCP Host) Claude、ChatGPT等需要透過MCP存取外部工具的AI模型,它們會請求MCP來幫助執行各種操作。這些AI模型就像筆電本身,需要透過轉接頭來連接外部裝置。 MCP客戶端(MCP Client) AI存取MCP的程式碼,它讓AI可以透過MCP 來請求特定的工具或數據來源。這就像筆電的USB連接埠,負責發送請求給轉接頭,讓筆電知道該怎麼存取外部設備。 MCP伺服端(MCP Server) Slack、Gmail、Google日曆、Mac檔案系統等,提供AI所需的功能與數據,可以是遠端應用程式或本地數據來源。MCP伺服器就像滑鼠、鍵盤、硬碟等各種USB設備,透過轉接頭連接到筆電。 舉例來說,使用者向ChatGPT提出請求:「幫我找出這週與總經理的會議紀錄,並寄送摘要。」 AI分析請求後,發現需要存取日曆數據、產生會議摘要和發送Gmail,便會透過MCP客戶端發送請求到MCP伺服端,請求使用「日曆存取」與「郵件發送」這兩種功能。過程中ChatGPT不用直接對接Google的API,而是統一透過MCP來取得數據。 目前Anthropic提供開源的MCP,包括Google Drive、Slack和GitHub在內,來自各個領域、超過1,000項服務已經開發MCP伺服器。早期使用者則以AI編寫程式的服務商為主,例如Google的Goose、Cursor和Cline,它們將MCP導入其AI系統中,利用MCP來提升產品服務。 以Cursor為例,MCP伺服器作為Cursor與外部工具或數據源之間的媒介,像是使用者可以從Google Drive調取數據檔案,也可以從GitHub創建任務分支和查詢程式碼。

打造AI的USB-C還有哪些挑戰?

目前MCP市場仍由Anthropic主導,要讓MCP成為普遍通用的標準,還需要主要的模型供應商都跟進採用。只是包含OpenAI、Google、AWS和Meta等公司,都尚未針對MCP給予標準化的承諾,和AI模型一樣,未來也可能出現多種MCP競爭的情形。 Google Deepmind資深AI開發關係工程師施密德(Philipp Schmid )就曾在社群媒體X(原Twitter)發文表示,MCP看起來只更適用於Anthropic的Claude,「如果他們(Anthropic)不納入其它供應商和開源社群,我懷疑這是否可以成為標準?只為一個供應商開發是沒有意義的。」 事實上,OpenAI過去也推出了函數調用功能(function calling feature),允許旗下GPT模型調用第三方的API,最近也為ChatGPT及其API推出了帶有網頁瀏覽、檔案搜索等AI代理的嵌入程式。這些功能和MCP一樣致力於將模型連接到外部功能,差別在於僅為OpenAI而生。 除此之外,MCP協定本身的複雜性對開發者而言也是一個挑戰,特別是在部署和維護過程中,企業需要大量的內部協作來確保系統平穩運行,因此,市場也預期會出現新興的託管服務。 即使目前MCP還在初期應用階段、還有許多待解問題,但以逐漸升溫的關注度看來,為AI打造更方便的萬能轉接頭,仍會是主要發展趨勢之一。

轉貼自: bnnext.com

若喜歡本文,請關注我們的臉書 Please Like our Facebook Page: Big Data In Finance

留下你的回應

以訪客張貼回應