智慧型手機,監視器和喇叭只是即將運行更多人工智慧軟體以加速圖像和語音處理任務的設備中的一小部分。被稱為量化的壓縮技術通過使深度學習模型更小以減少計算和能量成本。但事實證明,因為越來越多複雜的決策被轉移到機器上,較小的模型越容易使惡意攻擊者欺騙AI系統而導致不良行為。

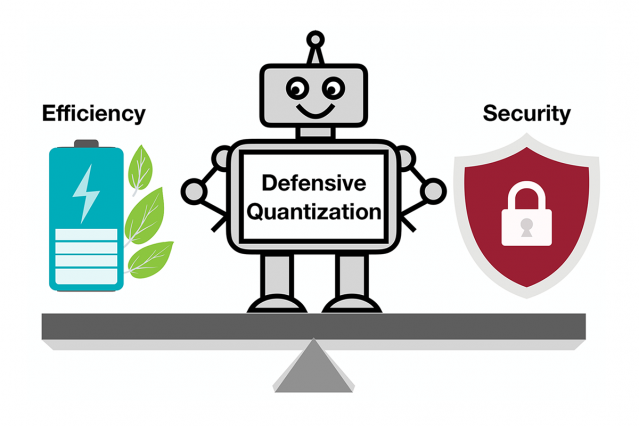

最新研究指出,美國麻省理工學院和IBM的研究人員展示壓縮後的人工智慧模型對敵意攻擊有多麼脆弱,他們提供的解決辦法:增加一個數學式的限制在量化過程中能減少成為攻擊對象使其墮入略加修改圖像並錯誤區分他們所見物件的可能性。

當一個深度學習模型從標準的32位元降低到較低的位元,它更可能由於誤差放大效果錯誤地分類改變的圖像:被修改後的圖像隨著處理的層數增加變得更加的扭曲。最後,該模型更可能將一隻鳥誤認為是貓,或者將一隻青蛙誤認為是鹿。

8位元或更少的模型是對敵意性攻擊更加敏感,研究人員表明,隨著位元寬度降低,精準度從已經30-40%下降到低於10%。但是在量化期間控制Lipschitz constraint可以恢復一些彈性。當研究人員添加此限制時,他們在攻擊中看到了小幅的性能提升,在某些情況下較小的模型甚至優於32位元模型。

電子工程和計算機科學的MIT助理教授 Song Han說“我們的技術限制了誤差的放大和甚至可以使壓縮深度學習模型比完全精準的模型們更穩健”,麻省理工學院的微系統技術實驗室的成員說。 “通過適當的量化,我們可以限制誤差。”

該團隊計劃通過在更大的數據集上進行培訓並將其應用於更廣泛的模型來進一步改進該技術。 “深度學習模型需要是快速和安全的,因為他們進入互聯網連接設備的世界裡,”,在麻省理工學院人工智能實驗室,IBM Watson研究人員說。 “我們的防守式量化技術在兩方面都有所幫助。”

在使AI模型更小,以便它們運行更快並且使用更少的能量時,使用AI本身來提高模型壓縮技術的極限。在最近的相關研究中,Han和他的同事們展示學習如何增強可用於自動為基於設備如何快速運行的模型可以處理圖像的量化模型中的每一層的最小位元長度。 Han表示,與固定的8位模型相比,這種靈活的位寬方法可將延遲和能耗降低200%。研究人員將在6月的計算機視覺和模式識別會議上展示他們的發現。

轉貼自: MIT NEWS

若喜歡本文,請關注我們的臉書:Big Data In Finance

留下你的回應

以訪客張貼回應